Cuando pensamos en el Sol, la imagen instantánea que nos viene a la mente es la de una esfera amarilla, luminosa y cálida en un cielo azul. Sin embargo, ese aspecto amarillo-dorado no es más que una convención estética: una manera de acercar la fotografía solar a lo que nuestra experiencia cotidiana nos dicta que “debe ser” el Sol. Es por eso que cuando coloreamos nuestras imágenes es habitual generar una imagen final en la que intentamos aproximarnos a ese convencionalismo cromático de naranjas, amarillos y dorados.

Pero la realidad es muy distinta. El Sol observado desde el espacio, fuera de la atmósfera terrestre, emite una luz blanca ligeramente cálida ya que emite luz en todo el espectro visible Cuando esa luz llega a la atmósfera terrestre y choca con las moléculas de aire se desvía en todas direcciones. Las longitudes de onda más cortas (azules) se dispersan mucho más que la largas (rojo). Por eso el cielo se ve azul durante el día y el sol lo observamos con los tonos típicos amarillos-dorados ya que esa luz a perdido parte de su componente azul al ser dispersada por la atmósfera. Es lo que se conoce como dispersión de Rayleigh.

En realidad, cuando los astrónomos y astrofotógrafos exploran el Sol con filtros específicos —capaces de aislar bandas de longitud de onda muy concretas—, el resultado no tiene color, sino que es una imagen monocroma, estrictamente en blanco y negro. ¿Por qué? Porque los sensores, incluso los de cámaras a color, están formados por millones de píxeles monocromos. En los sensores RGB, un filtro rojo, verde o azul delante del píxel hace que solo los fotones correspondientes a ese color lleguen al sensor en cada punto, y el procesado posterior reconstruye la imagen en color; sin embargo, esto implica pérdida de resolución y sensibilidad.

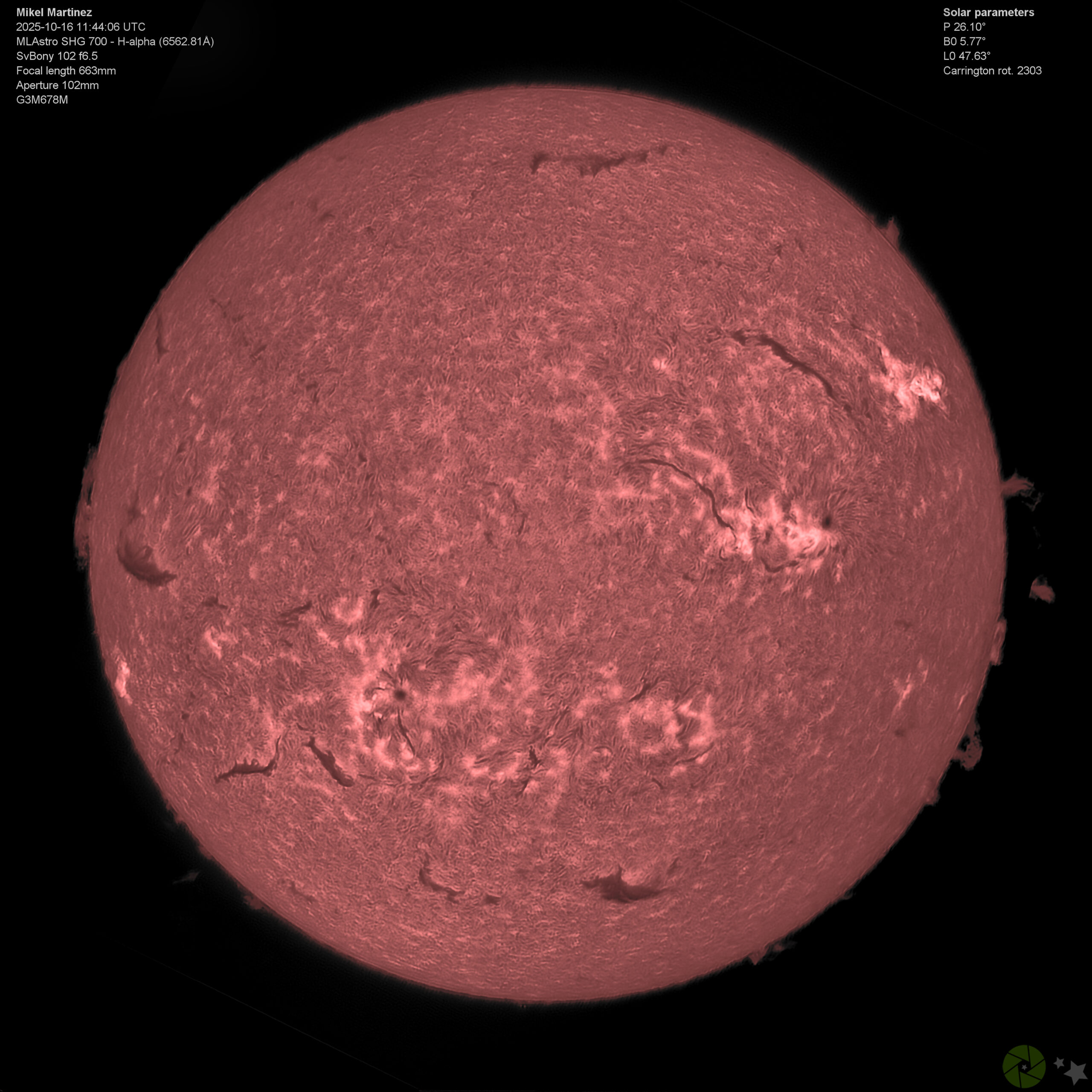

En fotografía solar científica, la prioridad absoluta es capturar el mayor número posible de fotones de una sola longitud de onda—por ejemplo, la de H-alfa, esencial para estudiar la cromosfera solar—, por lo que se usan sensores monocromos puros (sin matriz de Bayer), optimizando así la calidad y la nitidez.

No obstante, cada línea espectral —H alfa, H beta, Mg(b1)— corresponde físicamente a un color particular dentro del espectro visible del ojo humano. Si coloreamos artificialmente las imágenes usando el código RGB que corresponde a la longitud de onda exacta de cada filtro, estamos mostrando el color real de cada emisión solar.

-

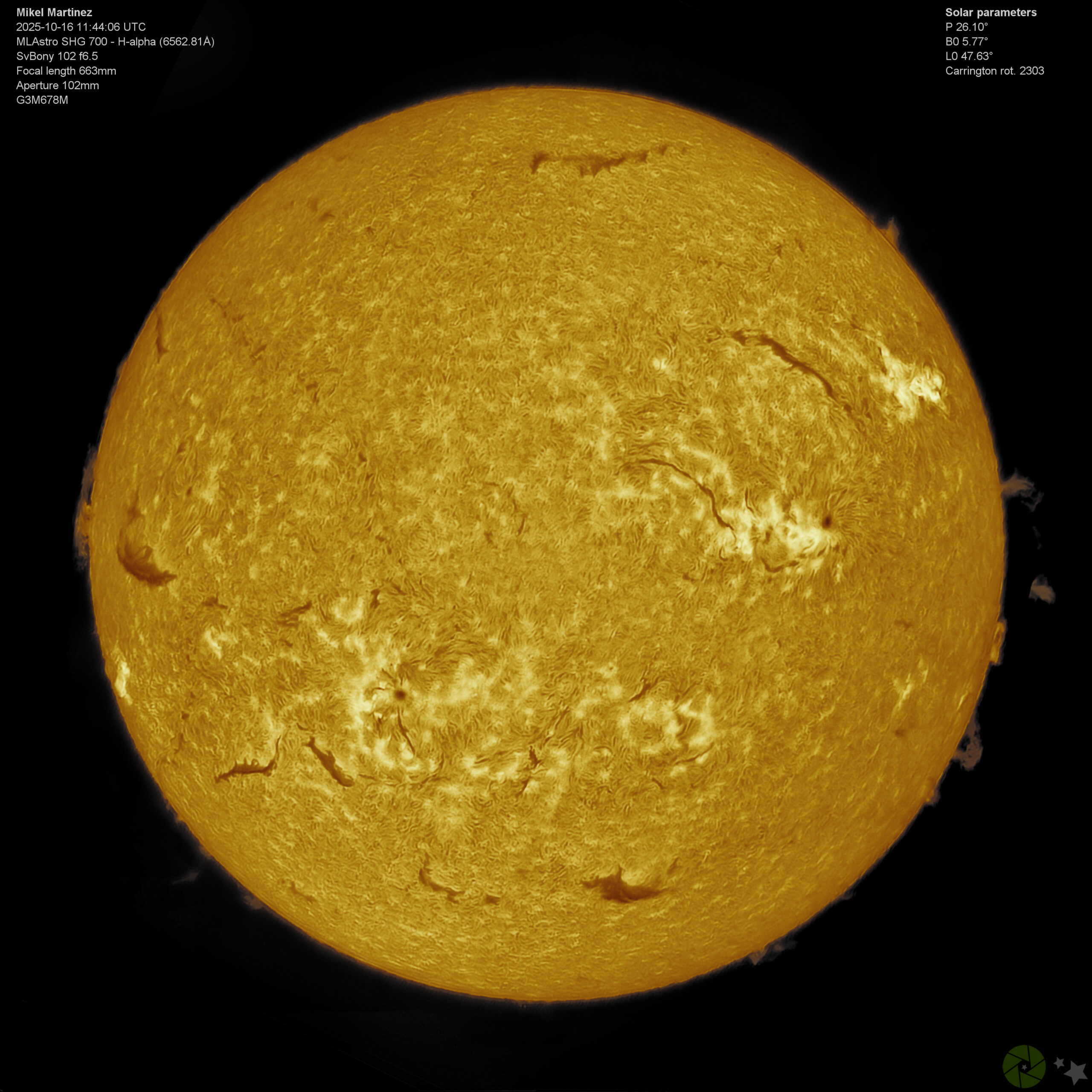

Mg b1 (518.4 nm, RGB 47, 255, 0): Un verde esmeralda intenso, justo en el centro del espectro solar visible.

-

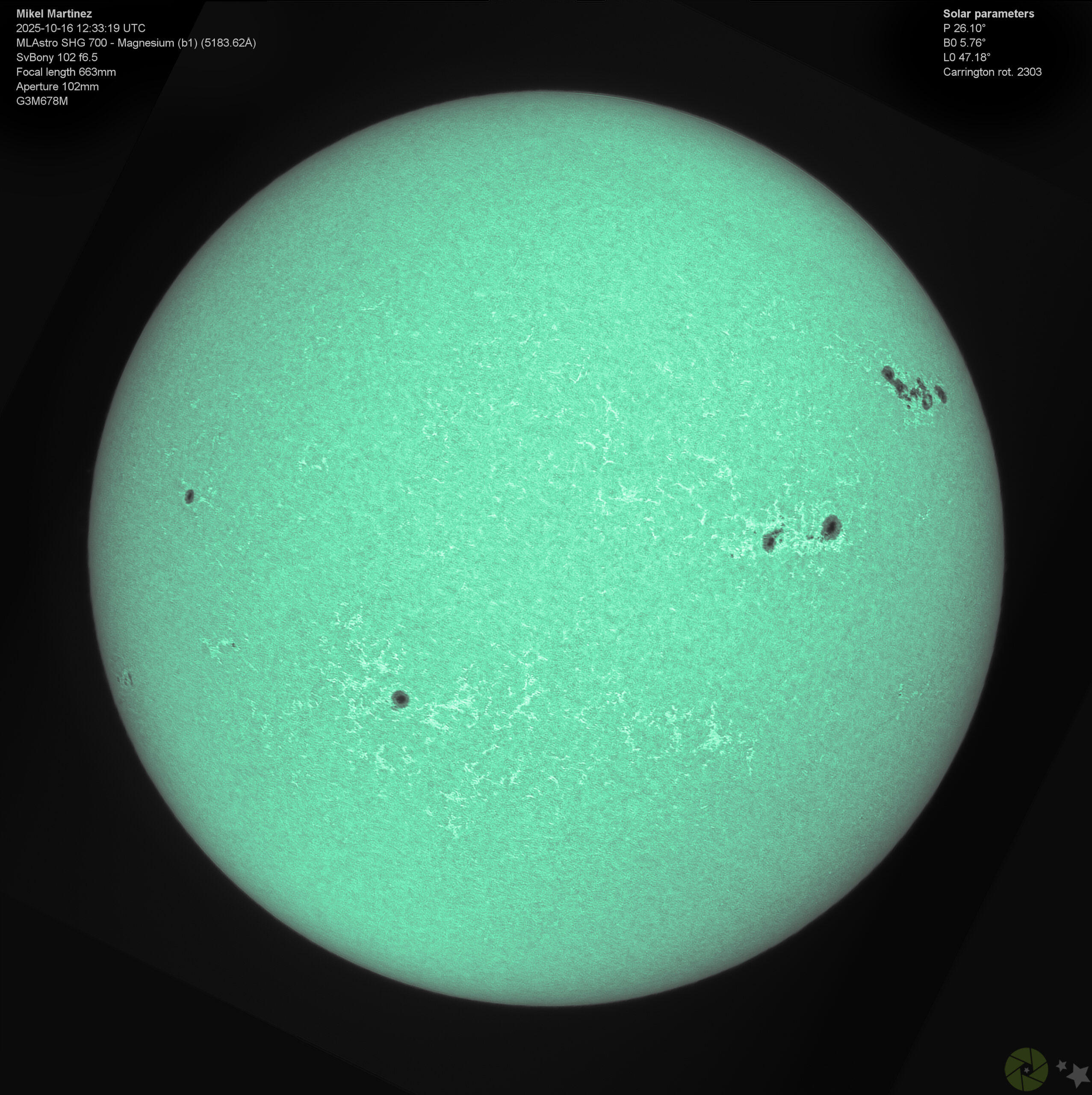

H beta (486.1 nm, RGB 0, 239, 255): Un azul turquesa puro, típico del brillo de las emisiones de hidrógeno de alta energía, que nos muestra una capa intermedia de la cromosfera.

-

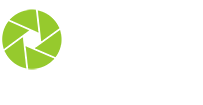

H alfa (656.3 nm, RGB 255, 0, 0): Rojo puro, El color predominante de la zona de la cromosfera donde se producen los fenómenos más espectaculares —filamentos, protuberancias, espículas— de la atmósfera solar.

Al colorear así nuestras imágenes tenemos que decidir si nuestro objetivo es meramente estético o queremos aproximamos a una percepción “física” del color. No una interpretación artística ni una aproximación convencional, sino que sea una conexión directa entre la naturaleza de la luz y la sensibilidad de la retina humana.